Prima di andare ad analizzare cosa possa essere interpretato come Metaverso oggi, è necessario distinguere tra situazioni nelle quali ci si immerge e situazioni nelle quali si è immersi, le seconde sono più effettive delle prime e potenzialmente più dirompenti perché accadono senza una razionalizzazione.

La risposta di Mullins, founder and CEO, Aglet, riguardo alla possibile definizione di Metaverse è una sintesi storica utile per aprire una analisi a proposito:

“And then we got to this next phase, which was what Facebook perfected—making people and social networks machine-readable so that you can apply algorithms to them and then advertise. That was mobile-social-cloud, and the separation between online and offline became much more blurred. Where we’re going now is this ‘web 3.’ Now it’s about a spatial web—how does the virtual come off the screen and be baked into the fabric of reality… it’s really about virtual and physical sharing the same space; which is just the world.”

L’hype dell’ultimo anno nella definizione di una soluzione linguistica condivisibile rispetto al futuro del web si è sintetizzata nel concetto di “Metaverse”. Ma questa è la seconda parte della storia.

Prima del Metaverse, o della sua possibile definizione concettuale, questa corsa al nuovo concetto va inserito nell’attuale stato dell’arte della rete e visto attraverso la sua ormai matura dimensione infrastrutturale basata su Cloud, NPU, AI, CDN server, architetture a microservizi e container, API driven SaaS, e, soprattutto attraverso un approccio statefull serverless che possa connettere all’edge qualunque rete distribuita, organizzazione o processo e che possa gestire in sincronia ogni nodo che opera asincrono orchestrando senza soluzione di continuità la periferia e il centro mantenendo una perfetta consistenza e disponibilità del dato.

Questi ad oggi i main player nell’industria:

Cloudflare può essere preso come attore paradigmatico in questa ridefinizione infrastrutturale avviata da un decennio. Cloudflare pur essendo diventato nel 2021 il quarto provider di servizi cloud al mondo è lontano dal potersi definire un reale incumbent e grazie ad un approccio super lean, sta cercando di rendere realmente effettivo questo paradigma.

Proprio in questo ultimo anno, Cloudflare, grazie all’introduzione dei Durable Objects, ancora in beta, al nuovo servizio di storage R2, agnostico rispetto al proprio ecosistema e gestito con API totalmente compatibili con Amazon S3, unito al Distributed Web Gateways anch’essi in beta, sembra aver fatto un passo avanti in questa direzione.

Stratechery

“Durable Objects are the missing piece in the Workers stack that makes it possible for whole applications to run entirely on the edge, with no centralized “origin” server at all.

…

When using Durable Objects, Cloudflare automatically determines the Cloudflare data center that each object will live in and can transparently migrate objects between locations as needed.

Traditional databases and stateful infrastructure usually require you to think about geographical “regions”, so that you can be sure to store data close to where it is used. Thinking about regions can often be an unnatural burden, especially for applications that are not inherently geographical.

With Durable Objects, you instead design your storage model to match your application’s logical data model. For example, a document editor would have an object for each document, while a chat app would have an object for each chat. There is no problem creating millions or billions of objects, as each object has minimal overhead”

Cloudflare

Che la definizione di questo passo avanti sia fondamentale o marginale è ora indifferente, ma testimonia la direzione che l’infrastruttura cloud sta necessariamente inseguendo nell’integrazione di un reale statefull serverless. Cloudflare apre le porte a un nuovo modo di programmare oltre che a un nuovo modello di vendere determinati servizi, e propone una visione integrale:

“ We see Durable Objects as a low-level primitive for building distributed systems. Some applications, like those mentioned above, can use objects directly to implement a coordination layer, or maybe even as their sole storage layer.

However, Durable Objects today are not a complete database solution. Each object can see only its own data. To perform a query or transaction across multiple objects, the application needs to do some extra work.

That said, every big distributed database – whether it be relational, document, graph, etc. – is, at some low level, composed of “chunks” or “shards” that store one piece of the overall data. The job of a distributed database is to coordinate between chunks.

We see a future of edge databases that store each “chunk” as a Durable Object. By doing so, it will be possible to build databases that operate entirely at the edge, fully distributed with no regions or home location. These databases need not be built by us; anyone can potentially build them on top of Durable Objects. Durable Objects are only the first step in the edge storage journey.”

Cloudflare

Il Metaverse ha poco o nulla a che fare per il momento con VR, AR, crypto, se non al pari di come potrebbe essere introdotto o immaginato come promessa, ma è più realisticamente oggi un’opportunità infrastrutturale matura. Come descritto qui a riguardo dell’e-commerce, lo stesso vale per ogni trasformazione tecnologica incombente: il sottostante è sempre una completa maturazione infrastrutturale, in questo caso da riferire in primis alla possibilità di avere una rete distribuita e che lavora in maniera asincrona ma perfettamente coordinata direttamente all’edge della rete stessa, eliminando ogni sintomo di latenza:

“…durable Objects sit at the opposite end of the storage spectrum from KV. They are extremely well-suited to workloads requiring transactional guarantees and immediate consistency. However, since transactions inherently must be coordinated in a single location, and clients on the opposite side of the world from that location will experience moderate latency due to the inherent limitations of the speed of light. Durable Objects will combat this problem by auto-migrating to live close to where they are used.

In short, Workers KV remains the best way to serve static content, configuration, and other rarely-changing data around the world, while Durable Objects are better for managing dynamic state and coordination.”

Cloudlfare

Infine, la logica introdotta dai Durable Objects permette di gestire le restrizioni giurisdizionali e quindi relative allo storage fisico dei dati inserendo un ID nell’oggetto che ne gestisce poi migrazioni e spostamenti mentendo però sempre traccia e assicurando compliance con le restrizioni relative alla giurisdizione alla quale il dato deve rispondere, in aggiunta a ciò verrà anche rilasciata una feature che promette l’adattamento automatico dell’oggetto alla giurisdizione nella quale questo eventualmente migrerà:

Today, we only support the EU jurisdiction, but we’ll be adding more based on developer demand.

By setting restrictions at a per-object level, it becomes easy to ensure compliance without sacrificing developer productivity. Applications running on Durable Objects just need to identify the jurisdictional rules a given Object should follow and set the corresponding rule at creation time. Gone is the need to run multiple clusters of infrastructure across cloud provider regions to stay compliant — Durable Objects are both globally accessible and capable of partitioning state with no infrastructure overhead.

In the future, we’ll add additional features to Jurisdictional Restrictions — including the ability to migrate your Objects between Jurisdictions to handle changes in regulations.

Cloudflare

Cloudflare fa così un salto avanti rispetto alle altre soluzioni serverless. Laddove con AWS, o altri servizi, devi disporre delle API che interagiscono con un database, con la logica introdotta dai Durable Obejects invece basta descrivere la classe.

Per quelle applicazioni che hanno bisogno di condividere dati in realtime e restituire sincronia partendo da stati asincroni, questa è una nuova dimensione con una nuova impostazione logica che rivoluziona una precedente senza però distruggerla.

“So how can we apply the serverless philosophy to state? Just like serverless compute is about splitting compute into fine-grained pieces, serverless state is about splitting state into fine-grained pieces. Again, we seek to find a unit of state that corresponds to logical units in our application. The logical unit of state in an application is not a “table” or a “collection” or a “graph”. Instead, it depends on the application. The logical unit of state in a chat app is a chat room. The logical unit of state in an online spreadsheet editor is a spreadsheet. The logical unit of state in an online storefront is a shopping cart. By making the physical unit of storage provided by the storage layer match the logical unit of state inherent in the application, we can allow the underlying storage provider (Cloudflare) to take responsibility for a wide array of logistical concerns that previously fell on the developer, including scalability and regionality.”

Cloudflare

Se riprendiamo il cammino storico del cloud, si può facilmente osservare, al netto della ovvia quantità di dati gestiti, che il prezzo del servizio di cloud storage si è abbassato drasticamente e che mantiene però oggi un ultimo gain marginale sull’esportazione dei dati, R2 di Cloudflare rende questo margine nullo dando sempre libertà di esportazione e questo a vantaggio di una proprietà certa del dato, non tassato, (questo è un passaggio fondamentale) e della facilità di integrazione modulare con altri servizi, i migliori a disposizione idealmente, questa visione si completa con l’introduzione dei Distributed Web Gateways, annunciati in beta a inizio ottobre (01/10/2021) con un post aziendale con titolo allusivo ”Announcing The Cloudflare Distributed Web Gateways Private Beta: Unlocking the Web3 Metaverse and Decentralized Finance for Everyone”.

“We found that there was a unique opportunity in a segment of the Web3 community that closely mirrored Cloudflare’s traditional customer base: the distributed web. This segment has some major usability issues that Cloudflare could help solve around reliability, performance, and caching. Cloudflare has an advantage that no other company in this space — and very few in the industry — have: a global network. For instance, content fetched through our IPFS Gateway can be cached near users, allowing download latency in milliseconds. Compare this with up to seconds per asset using native IPFS. This speed enables services based on IPFS to go hybrid. Content can be served over the source decentralised protocols while browsers and tools are maturing to access them, and served to regular web users through a gateway like Cloudflare. We do provide a convenient, fast and secure option to browse this distributed content”.

It’s an exciting time. Unlike the emergence of the Internet, however, there are large established companies that want to control the shape and direction of Web3 and this Metaverse. We believe in a future of a decentralised and private web. An open, standards-based web independent of any one company or centralizing force. We believe that we can be one of the many technical platforms that support Web3 and the growing Metaverse ecosystem. It’s why we are so excited to be announcing the private beta of our Ethereum and IPFS gateways. Technologies that are at the forefront of Web3 and its emerging Metaverse”

Cloudflare

Riprendendo quindi i 7 eventuali livelli che dovrebbero dare consistenza al concetto di Metaverse: questo sembra sicuramente una visione costruita on top di un’infrastruttura e all’interno della quale alcuni layer rimangono al momento solo ipotesi, mentre le nuove potenzialità legate allo sviluppo e piena maturazione dell’infrastruttura IT, nella sua complessità, fanno capire come in realtà in parte stiamo già facendo esperienza in diversi modi di quella che sarà a tutti gli effetti una nuova modalità di esperienza del reale, mediata proprio dai dati che l’infrastruttura gestisce con sempre maggior pervasività:

Quest’osservazione di Benidict Evans in una colonna dedicata all’argomento è una sintesi perfetta di quello che è lo stato d’animo all’interno del quale la percezione di una nuova dimensione vuole tradursi in concetto senza però un focus preciso:

“If the ‘metaverse’ means anything, it reflects that we have all grown up with this now, and we’re looking at ways to absorb it, internalise it and reflect it in our lives and in popular culture – to take ownership of it. When software eats the world, it’s not software anymore.”

La raccolta e gestione di dati e la loro manipolazione asincrona da e per i nodi che operano all’edge delle reti (siano questi utenti, sensori, agenti virtuali costruiti per testare scenari o persone che interagiscono tramite un qualsiasi medium digitale) sono processi sempre volti a ridefinire la prospettiva con la quale questi dati sono disposti e eventualmente restituiti con informazioni aggiuntive.

Questo accade in maniera indifferenziata se l’agente che decide le informazioni da disporre sia un algoritmo di ottimizzazione della guida autonoma o quello che definisce un feed su un social network.

Metaverse in questo senso ci appare quindi come concetto nato dal nostro quotidiano accesso ad una realtà mediata da un layer che opera vitalizzando la realtà, che opera in maniera asincrona, ma verso il quale però pretendiamo che al netto di ciò ci sia sempre in quello che viene disposto una fondamentale sincronia.

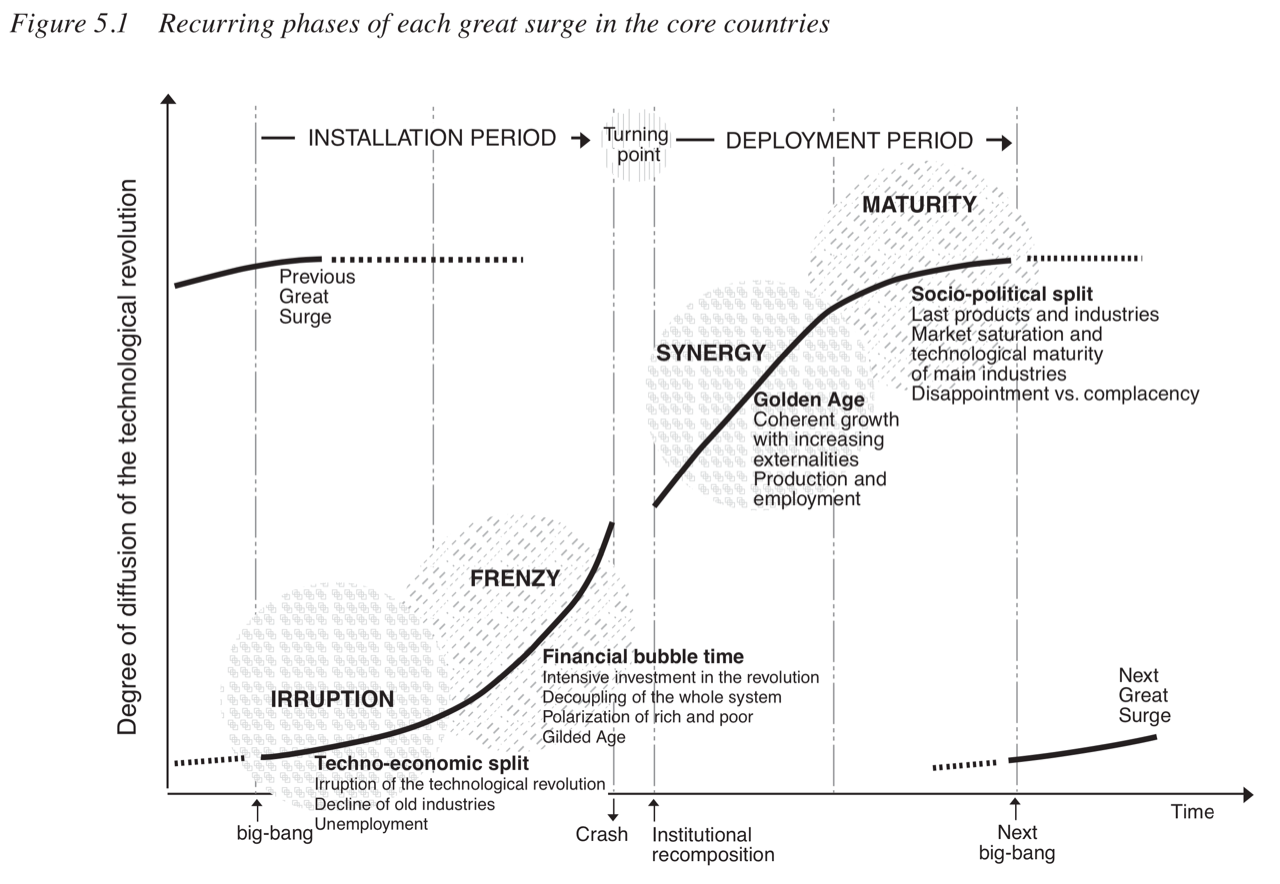

All’interno di quello che può ormai definirsi come pragmatico relativismo informativo, laddove l’informazione ha la possibilità nonché la necessità di adattarsi in maniera immediata al luogo e al momento, l’installazione tecnologia è fondamentale per giungere a quella Golden age, relativa qui all’IT, che Carlota Perez descrive in Technological Revolutions and Financial Capital was its timing: 2002, in cui viene argomentato come siano le infrastrutture a dettare il tempo alle rivoluzioni:

Il fatto di essere inseriti in una realtà che quotidianamente si pone come relativismo informativo con il fine di ottimalizzare la sua efficienza generale, uno stato spesso avvertibile come ridondanza, è ormai un sentimento celato ma comune. Questo sentimento declinato sull’infrastruttura di riferimento, quella IT che lo dispone pragmaticamente, è un indizio relativo all’ingresso in una nuova fase nella traiettoria qui descritta.

La base logica dei processi computazionali per risolvere questa complessità informativa dipenderà poi sempre di più a livello basico dalla disposizione compiuta di chip disegnati ad hoc per processi determinati, come nueromorphic chips, che spaccano al minuto la legge di Moore, vedi Intel con l’introduzione di Loihi 2.

In parallelo il quantm computing sembra confermarsi intrinsecamente il miglior candidato a gestire nel lungo termine la necessaria complessità di calcolo per mantenere sempre un sincrono un universo informativo che si pone però in maniera asincrona in ogni suo nodo.

La normalizzazione della legge di Moore su scala Q-Bit è infatti risolta se i valori dell’ascissa vengono espressi in scala logaritmica, ciò significa che entro il 2040 verranno tendenzialmente raggiunti obbiettivi posti, stando alla codifica binaria, nel 2719 (vedi the Goliath Machine).

In questa ottica di analisi prettamente infrastrutturale volta a contestualizzare la riesumazione del concetto di Metaverse, Tesla, proprietaria di una delle reti neurali più avanzate al mondo, mostra come l’introduzione di chip disegnati per servire questo tipo di compito e la disposizione sul campo di una rete, le sue auto, poste all’edge del processo di sviluppo industriale, permetta un’implementazione senza precedenti della suo prodotto core, l’edge-AI, con nodi distribuiti e utenti che quando si siedono su un’auto sono già all’interno di un Reversed Metaverse.

“For a very simple example of edge computing and its relationship to the cloud, consider a Tesla. The car’s many sensors and cameras can only have situational awareness if they can respond to what they’re seeing—whether trees, other cars, or traffic—in near real-time. There isn’t the time, latency, or bandwidth to send data back to a central, public cloud data center. Instead, the cloud must be brought to the edge.

Thus, a Tesla isn’t just a next-generation car; it’s an edge compute node. But even with Tesla, a relatively straightforward use case, building and deploying the edge node is just the beginning. In order to unlock the full promise of these technologies, an entire paradigm shift is required.

…

Only by seeing the cloud as an operating model as opposed to a finish line will the benefits of 5G and AI be realized. Those transformations won’t happen if organizations aren’t taking the necessary steps to be cloud-native and cloud-secure.“

www.nextgov.com

Questo si lega direttamente alla messa in produzione da parte di Tesla del nuovo chip Dojo che gestisce i processi di AI.

“Tesla hasn’t put that system together yet, but CEO Elon Musk claimed that it will be operational next year.

It would become the fatest AI training computer in the world while being power efficient and in a relatively small format for a supercomputer.

Tesla plans to use the new supercomputer to train its own neural networks to develop self-driving technology, but it also plans to make it available to other AI developers in the future.”

Da Tesla per ritornare a Cloudflare il Metaverse, escluse le visioni di immersione diretta, si mostra quindi come l’inizio di una fase più matura dell’infrastruttura IT che si prepara a disporre, a prescindere del medium, tutta la propria reale potenza.

Subspace, fondata nel 2018, è in prospettiva e infine un’altro esempio imprescindibile per argomentare a livello di paradigma quello che sarà lo stato dell’arte di un infrastruttura votata a dover gestire la latenza e la presenza coordinata con una consistenza decisamente più solida:

Subspace uses custom global routers and routing systems, as well as dedicated fiber mesh networks, to provide alternative pathways for routes that, for one reason or another, tend to suffer from latency more than most. This hardware has been installed inside more than 100 data-center facilities worldwide. An IT administrator can easily arrange to route outgoing traffic through the Subspace network and thus get that traffic to its destination sooner than the traditional public domain name system (DNS) could manage.

Al netto di ciò si apre l’opportunità di immaginare il Metaverse come distribuzione e ottimizzazione del flusso informativo a supporto della produzione a prescindere della messa a punto o meno di medium alternativi.

Un Reversed Metsaverse è in parte già in fase di deployement e il fatto che ponga il consumer come un nodo all’edge del processo lascia intendere come questo sia molto più profondo a livello di impatto che una semplice riedizione virtuale del mondo via VR / AR.

In parallelo a questo rimarrà aperta un’enorme sfida di regolazione alla quale le istituzioni dovranno rispondere normalizzando la disposizione di questi processi.

La tecnologia alla base della decentralizzazione finanziaria potrebbe qunidi diventare la base infrastrutturale per il controllo e la regolazione dei flussi informativi. Questo che appare come un contrappasso, non è uno sviluppo ovvio ma sicuramente logico e con esso potrebbero cambiare forma anche le istituzioni, seguendo sempre la teoria di Perez:

Ben Thompson ha infatti ripreso direttamente questa teoria aprendo un confronto diretto con Perez:

That seems awfully descriptive of the current era, no? Products that break through reach saturation in record time (see TikTok reaching a billion users in three years, or DTC companies that seem to max out in only a couple of years), while the future of established companies seems to be quagmire in legislators and the courts, even as profits continue to pile up without obvious places to invest. And if the government’s response to the revolution has been disappointing, that also may be because of the revolution itself.

Moreover, to the extent the dystopian picture above is correct — that the real synergy has been between centralized governments and centralized tech companies, to the alarm of both those abroad and in the U.S. — the greater the motivation there is to make the speculative investments that drive the next paradigm, especially if that paradigm operates in direct opposition to the current one. To be sure this framework does imply that crypto is full of scams and on its way to inflating a spectacular bubble, the aftermath of which will be painful for many, but that is both expected and increasingly borne out by the facts as well. What will matter for the future is how much infrastructure — particularly wallet installation — can be built-out in the meantime.

For what it’s worth my suspicion is that the current Installation period for crypto — if that is indeed where we are — has a long ways to run, which is another way of saying most of the economy will remain in the current paradigm for a while longer. The time from the Intel microprocessor to the Dotcom Bubble bursting was 30 years (and, it should be noted, there were a lot of smaller, more localized bubbles along the way); Satoshi Nakamoto only published his paper in 2008. Thirteen years after 1971 was 1984, the year the Mac was introduced; the browser was another 9 years away. It’s one thing to see the future coming; it’s something else entirely to know the timing. On that Perez and I can certainly agree.

Ben Thompson – Stratechery

Molte cose rimarranno ancora per un po’ apparentemente simili a come le conosciamo, mentre in realtà ci stanno già traghettando all’interno di un Metaverse invertito sempre più pervasivo ed effettivo, differente da come lo si potrebbe immaginare ma del quale è obbligatori prendere atto.

La dirompenza dell’infrastruttura, quando detta i tempi delle rivoluzioni, è nel suo rimanere nascosta e funzionare senza attriti, mentre si perfezione diventa indispensabile e vitale. Per questo motivo si parla di Metaverse, come reazione inconscia e collettiva all’attuale ingresso in un’epoca in cui l’infrastruttura IT inizia ad occupare un ruolo sempre più centrale nel quotidiano, più di quanto si sia razionalmente disposti ad accettare.

Molto difficile capire se stiamo entrando in un punto di trasformazione, molto probabilmente stiamo in uno stato precedente in cui però si può intravedere la reale potenza che deve però ancora essere disposta per rimodellare le istituzioni sociali ed economiche, è piuttosto l’inizio di una sostanzale fase di “deployment”.

La nuova posizione strategica di Sequoia Capital sembra certificare in qualche modo questa prospettiva di extremely long-run, la disposizione di capitali finanziari immobilizzati che diventano sostanzialmente capitali produttivi e prospettano l’occasione di un salto di qualità per essere al centro di questo più lungo periodo di installazione “pesante”.

Processi industriali AI Driven, Crypto, Public Cloud e Remote Working renderanno probabilmente il capitale produttivo molto meno vincolato mettendo le basi con questa impostazione a una nuova maturità istituzionale oltre che finanziaria.

Qui il follow-on di Ben Tomphson sull’argomento relativo alla nuova strategia di Sequoia:

“his also, I suspect, represents the formation of a sort of “Silicon Valley Inc.”; while the big 5 can entirely self-fund, the nature of the SaaS business model is such that companies with proven product-market fit are better off losing more money up-front rather than less:

Customers, once acquired, are like annuities that make money years into the future, but the cost to acquire them has to be paid up front.

The core software product represents a huge fixed cost investment that is leveraged by scaling to as many customers as possible.

The combination of these two factors means that SaaS companies take longer to self-fund, even if their models are proven; what Sequoia can do with their model is invest in an entire portfolio of these companies and hold onto them indefinitely, effectively recycling money from mature companies into nascent ones, much as Apple or Microsoft invests profits from their current products into the development of new ones. On an individual company level it looks like venture/financial capital; as a collective it is much more akin to production capital, especially once you realize that many of these companies, thanks to angels and AWS, are already fairly de-risked.

Moreover, while Sequoia’s announcement feels so momentous because of their long history in the Valley, institutions like Tiger Capital are already playing the exact same game; the era of production capital is firmly upon us, which means we are clearly in the Deployment period of Perez’s model.

Mentre si immagina una dimensione parallela dove spostare questa dipendenza, la forza di gravità di chi già opera in questa dimensione aumenta, il processo entra in una fase irreversibile e alcune cose allo stato larvale, come il Metaverse sono immaginate perché orma intuite.”

Stratechery

Mentre si immagina il Metaverse come una dimensione parallela dove spostare questa dipendenza dall’infrastruttura, la forza di gravità di chi già opera in questa dimensione aumenta e quello che dovrebbe sussistere come separato è nei fatti sempre più persistente.

Tesla nel Q4 2021 si sta preparando a lanciare i driver profile come cloud profile: ogni guidatore in automatico avrà la propria esperienza di guida replicata su ogni Tesla nella quale si metterà alla guida.

Tesla is preparing for a world where your driver profile can follow you across different cars, be it your personal EV or a rental. The car maker has added a Cloud Profiles section in its latest software release, which points to an “Enable Vehicle Sync” option for backing up driver profiles, Tesla Software Updates reports. The news isn’t a huge surprise, as Elon Musk previously said cloud-synced profiles were on the way.

Come ultimo punto di attenzione non si può non includere l’Omniverse lanciato da Nvidia nel Q3 2021.

Omniverse Replicator is a tool that should ultimately help organizations build better digital twins — and thus, better AI-powered tools in the real world. Nvidia is introducing two different applications built with Replicator, which demonstrate some of its use cases: The first application is Nvidia Drive Sim, a virtual world for hosting the digital twin of vehicles. Next, Nvidia Isaac Sim is a virtual world for the digital twin of manipulation robots.

…

To further demonstrate the value of digital twins, Nvidia showcased two customer stories. First, Ericsson is using Omniverse to build digital twins for 5G networks. The telecom equipment maker is building city-scale digital twins to help accurately simulate the interplay between 5G cells and the environment. This should help optimize 5G performance and coverage.

Zdnet

Questo è un tassello importante nella transazione verso la virtualizzazione dell’enviroment, che sia sociale o prettamente fisico come in questo caso, ed è un esempio ulteriore a validazione della tesi che si ancora è in una fase decisa di transizione infrastrutturale, epocale, e lo spostamento delle dinamiche fisiche su piattaforme parallele dove queste tendono a e vogliono riprodursi nel modo più naturale e più accessibile possibile alle esigenze attuali sta ora entrando in una prima incerta ma consisteste fase di deployment. Rimane da rimodulare il linguaggio logico alla base della programmazione di questi ambienti per adeguarlo totalmente alla nuova fase di installazione. Digital twins è un concetto più ampio ma più sensibile di Metaverse se si vuole comprendere lo stato globale di questa tendenza.

Extra content: Metaverse Premier

In questi 10 content pubblicati nel 2022 da Matthew Ball potete approfondire nella quasi totalità vari aspetti del concetto di Metaverso.